Prendre la mesure du pessimisme français

29 juin 2021

Un argent omniprésent

29 juin 2021 L’ère du réchauffement médiatique

L’ère du réchauffement médiatique

par Dominique Boullier, CEE

Que s’est-il passé ces dix dernières années dans notre système médiatique ? Comment a-t-on pu en arriver à un tel réchauffement médiatique, qui est avant tout un échauffement général des esprits sous l’emprise d’un rythme de sollicitations et de réactions à haute fréquence ? Les réseaux sociaux « cool » des années 2000, du web 2.0, des contributions, ont été radicalement transformés et ont réussi à capter toute notre attention, en réception comme en production de messages et surtout d’images et de vidéos.

En adoptant une approche pluridisciplinaire du numérique, Dominique Boullier, professeur des universités en sociologie au Centre d’européennes et de politiques comparées (CEE), a publié Comment sortir de l’emprise des réseaux sociaux (Le Passeur, 2020). Un ouvrage utile pour contrer les impacts toxiques du fonctionnement actuel des réseaux numériques et de notre portable.

Peu avant 2010, Facebook, Twitter et YouTube ont été monétisés auprès des marques, en leur vendant des espaces publicitaires de plus en plus ciblés vers un public dont on prétend mesurer le taux d’engagement (sa réactivité) et non seulement son exposition. Toutes les interfaces ont été modifiées dans ce but. Le bouton Retweet, inventé en 2009, est devenu le dispositif principal de la viralité (plus besoin de recopier le tweet, ni même de le lire, et donc de faire une hiérarchie entre les tweets). De même, le hashtag qui résume un thème en un seul mot, le message qui, même à 280 caractères, reste très bref, ou encore les trending topics qui se calculent sur la vitesse de réaction des comptes Twitter à un tweet (et non sur sa popularité). Toute cette mécanique propre à Twitter, je la dénomme « l’horloge atomique de l’espace public », dans la mesure où même les journalistes finissent par sélectionner et hiérarchiser leurs sujets en tenant compte des indicateurs de Twitter. De même, avant 2010 , les boutons J’aime s’installent sur Facebook et les autres plateformes/réseaux sociaux, et l’affichage des scores de vues, de like, de partages, ce qu’on appelle les « vanity metrics », se généralise. Chacun court après des signaux de réputation, depuis les entreprises jusqu’à l’utilisateur ordinaire, en passant par le personnel politique, les people et même les chercheurs !

Une attention maintenue en état d’alerte

©Shutterstock

Notre attention a été petit à petit captée par ces plates-formes devenues des points de passage obligés, à l’aide de méthodes formalisées dans ce qu’on appelle la captologie. Tous ces éléments étaient déjà connus des sciences cognitives qui étudiaient la diversité des régimes d’attention selon qu’ils combinent la durée et l’intensité. Je propose de penser quatre régimes d’attention principaux :

- la projection : ce qu’on appelle habituellement être attentif, concentré, avec une intensité forte mais de durée faible car le coût cognitif est élevé,

- la fidélité : les habitudes, les routines, économes en termes d’énergie cognitive car nous fonctionnons alors en régime quasi automatique, avec une intensité faible mais sur une durée longue. Un régime qui répond à ce que recherchent les marques en quête de fidélisation de leur clientèle.

- l’alerte : le choc des photos, les notifications et tout ce qui nous sort de nos routines ou de notre tâche, avec une intensité forte mais sur une durée très brève, comme on le voit dans le buzz,

- l’immersion : être happé à l’intérieur d’un monde et l’accepter comme les univers des jeux vidéo, qui combinent la durée et l’intensité lorsque le jeu est bien conçu.

Si ces régimes d’attention ont été amplifiés par le numérique, c’est celui de l’alerte qui a pris le dessus via les réseaux sociaux. La captation de l’attention qu’ils mettent en place comporte deux aspects :

1/ l’effet de bulle de filtres, qui valorise les posts qui confirment notre vision du monde, nos habitudes, la fidélité, ce qu’on appelle le biais de confirmation. Les algorithmes de YouTube vont ainsi encourager la vision des vidéos similaires pendant des heures ;

2/ l’effet d’alerte qui favorise ce qui est nouveau (le « novelty score »), quitte à valoriser ce qui choque, ce qui fait horreur ou scandale. Un mode de fonctionnement qui explique notamment que les fake news se diffusent plus vite et se répandent plus loin que les autres messages, non pas tant par leur tromperie intrinsèque mais par leur aspect surprenant, choquant, qui nous alerte,nous pousse à réagir, à les répliquer, même s’il s’agit de les critiquer.

© Ascannio / Shutterstock.com

Ces effets d’alerte, produits par des algorithmes dits d’ »intelligence » artificielle, favorisent ce qui nous fait réagir pour augmenter notre score d’engagement.

Un engagement valorisé pour générer des revenus publicitaires

Ces deux effets – bulles et alertes – sont vendus, après calcul de profils et de « patterns », auprès des marques pour leur proposer des placements publicitaires attractifs. Le plus étonnant reste que les performances commerciales de ces investissements sont indémontrables. Les données recueillies, que l’on appelle « analytics », deviennent de plus en plus opaques et inaccessibles aux marques elles-mêmes mais toutes continuent à payer des montants invraisemblables aux deux plateformes dominantes (Google et Facebook captent 75% de la publicité en ligne) à travers des enchères elles-mêmes totalement opaques. Cette bulle de la publicité en ligne finira par éclater mais elle est encore utile pour fournir des signaux aux investisseurs puisque les marques elles-mêmes sont devenues des enjeux financiers plus que commerciaux désormais. Aucune marque ne souhaite donc se désengager la première, comme dans toutes bulles.

Des plateformes inadaptées pour le débat public

Pancarte lors des manifestations du 25 janvier 2011 au Caire © Essam Sharaf (CC BY-SA 3.0)

Les conséquences de ces choix et de ces dérives sont devenues graves pour notre espace public, invivables parfois pour le débat public. Au-delà du volume, de la visibilité donnée aux fake news et aux contenus haineux, le rythme de l’alerte permanente imposé par les plates-formes favorise la réaction immédiate au détriment de la réflexion, et finit par contaminer l’espace public. Mais il faut reconnaître que ces plateformes n’ont pas été conçues pour la discussion et la délibération démocratiques

Par exemple, lors des printemps arabes ou des mouvements sociaux de 2019 qui ont enflammé de nombreux pays, les plateformes se sont montrées utiles pour alerter et coordonner mais en aucun cas pour élaborer un programme ou organiser des débats.

Il est donc temps de réduire radicalement notre dépendance à ces plateformes.

Pour contrer la domination de ces dernières, les communautés du logiciel libre ont organisé leur propre réseau avec Mastodon. De son côté Jimmy Wales , co-fondateur de Wikipedia expérimente le WikiTribune Social. D’autres initiatives de ce type devraient être encouragées par les États s’ils veulent éviter un effondrement du système médiatique qui soutient l’espace public, construit depuis plus de 200 ans.

La réaction très récente de la classe politique et des États

© Shutterstock

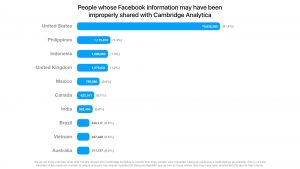

Mais les États traînent à réagir, eux-mêmes soumis à la séduction de ces tribunes de la vanité où le personnel politique croit gagner en popularité à travers des followers (qu’on peut acheter) et des likes et retweets (que des robots peuvent alimenter) alors qu’il devrait avant tout s’efforcer de gagner des élections sur la base de programmes ! De plus, les années 2010 ont été une période d’exaltation dogmatique libérale pour le modèle des plateformes, y compris celles qui comme Uber affichaient délibérément leur intention de saboter les règles établies dans les villes (un statut social pour les conducteurs, une responsabilité de la compagnie en cas de litige, etc). Rien ne devait se mettre en travers du business supposé porteur d’innovation même quand les plateformes ferment le marché par leur dumping ou leurs rachats. C’est seulement depuis le scandale de Cambridge Analytica en 2017, puis l’assaut du Capitole et la suppression des comptes Trump, que la classe politique mondiale a senti la menace vis-à-vis des institutions et de leur propre position. Ils prétendent tous réguler désormais, très mollement du côté européen avec le Digital Service Act et plus radicalement aux USA avec le récent Safe Tech Act que l’administration Biden essaye de faire passer au Congrès. C’est donc le bon moment pour démanteler les GAFAM (Google, Apple, Facebook, Amazon et Microsoft ).

Quatre démantèlements sinon rien !

Cependant, la vision purement industrielle (anti-trust) du démantèlement, analogue à celui de l’opérateur téléphonique AT&T réalisé en 1982 par Reagan, n’est plus adaptée. Par exemple, séparer Facebook d’Instagram et de WhatsApp ne sera guère suffisant pour réduire sa puissance, notamment publicitaire. Il faut également démanteler le modèle de rémunération publicitaire opaque en établissant des mesures indépendantes avec toutes les parties prenantes (les marques, les agences, les instituts de mesure, les représentants des usagers) et en séparant les régies publicitaires des fonctions remplies, comme un moteur de recherche ou un réseau social. Il faut aussi obliger les réseaux sociaux à devenir éditeurs et à réguler les contenus comme tous les autres médias et sans s’abriter derrière un statut d’hébergeur (voir le débat autour de la section 230 aux USA) qui devrait être réservé à ceux qui ont une pure fonction technique. Cela leur coûtera cher sans aucun doute mais ce serait plus simple que de leur demander de s’autoréguler en dehors de toute règle de droit sans pouvoir les sanctionner, comme les États tentent de le faire.

Le retour du droit contre le passage à l’acte

An Update on Our Plans to Restrict Data Access on Facebook Source Facebook, April 4, 2018 – Cliquer sur l’image pour l’agrandir

Ces plateformes sont nées dans un univers libertarien, dépourvu de culture juridique, et qui s’autorégule selon les principes « rough consensus and running code », c’est-à-dire que le code court toujours, qu’on expérimente en le mettant en oeuvre et en se contentant de produire des excuses quand les choses tournent mal, comme l’a fait Mark Zuckerberg tout au long de 2018 (notamment suite au scandale autour de Cambridge Analytica). Faire revenir ces plateformes dans le droit constitue un enjeu fondamental pour que les citoyens reprennent la main sur ces entités toutes puissantes. Le démantèlement devra ainsi porter sur leurs méthodes de captation de traces, qui sont en-deçà des données personnelles (des temps passés sur une page, des corrélations entre actions élémentaires telles qu’un clic, un like et un passage d’une page à une autre) que le Règlement général sur la protection des données (RGPD) peut difficilement traiter. L’ensemble de leurs algorithmes devront être auditables puisque leur taille devrait soumettre ces plateformes à des obligations de service public.

Réguler notre vitesse mentale collective

© Shutterstock

Enfin, le démantèlement de ces systèmes de captation de l’attention inscrits dans le design d’interaction permettra de ralentir la propagation des contenus. Il n’est pas nécessaire et souvent impossible – ni souhaitable – de toucher à la liberté d’expression (qui peut être régulée par la loi) mais rien n’oblige à subir les rythmes imposés par une liberté de propagation qui n’a pas vocation à être garantie par les lois des États démocratiques. Il est possible de s’attaquer au « Free Reach » pour casser les chaînes de contagion mentale sans remettre en cause le « Free Speech ». Les contrôles de vitesses mentales sont devenus des impératifs démocratiques ainsi que des enjeux de santé publique, comme ce fut le cas pour la vitesse sur les routes. « Code is law » disait le juriste américain Lawrence Lessig. En l’occurrence le design des interfaces et des algorithmes devrait permettre le ralentissement des propagations.

Selon une forme de riposte graduée, il faut imposer aux plateformes des interfaces où sont affichés les nombres de publications, de retweets, de réactions (plus que les durées d’écran qui ne sont pas significatives du rythme), puis la disparition des métriques de la vanité, puis l’affichage de régulateurs de vitesse où chacun peut s’autocontrôler, et enfin l’attribution de droits de tirage si aucune évolution n’est notée. Selon ces droits, chaque utilisateur pourrait poster un nombre X de contributions par plateforme par 24 heures, de partages, de likes, etc..Une fois ce quota atteint, il faudrait attendre le lendemain pour poster à nouveau. L’idée consiste à nous obliger les uns et les autres à sélectionner, donc à hiérarchiser, les informations que l’on publie et que l’on partage afin de jouer à nouveau un rôle de filtres normalement assuré par les médias. Puisqu’on prétend avoir transformé tout un chacun en média, il faut en assumer toute la responsabilité et devenir aussi éditeur responsable. Pour y parvenir, il faut que les plateformes soient contraintes par un cahier des charges qui, sur le mode du règlement général sur la protection des données (RGPD), conditionne leur accès au marché à la fourniture de ces instruments de régulation aux utilisateurs.

Si les dérives que l’on constate ont été une surprise, les réactions à adopter doivent être en prise avec les processus cognitifs et politiques en œuvre et non copier des règles adaptées à l’ancien régime médiatique. Alors que nous affrontons une crise climatique qui oblige à penser le long terme et notre survie, il serait catastrophique de rester équipés de médias qui paradoxalement nous encouragent à réagir toujours plus à court terme. Le réchauffement médiatique ne peut qu’aggraver le réchauffement climatique.

Dominique Boullier, sociologue et linguiste, est professeur des universités en sociologie à Sciences Po et chercheur au Centre des études européennes et de politiques comparées (CEE). Il enseigne à l’École du Management et de l’Innovation (« innovation et numérique : concepts et stratégies »), à l’École des Affaires publiques (« Pluralism of Digital Policies » et « Networks propagation and events management ») et à l’Executive School où il est responsable du module de sciences sociales du master Digital Humanities.

Comment sortir de l’emprise des réseaux sociaux, Le Passeur, 2020.

Previous publication: Sociologie du numérique, Armand Colin, 2019 (2ème édition révisée).